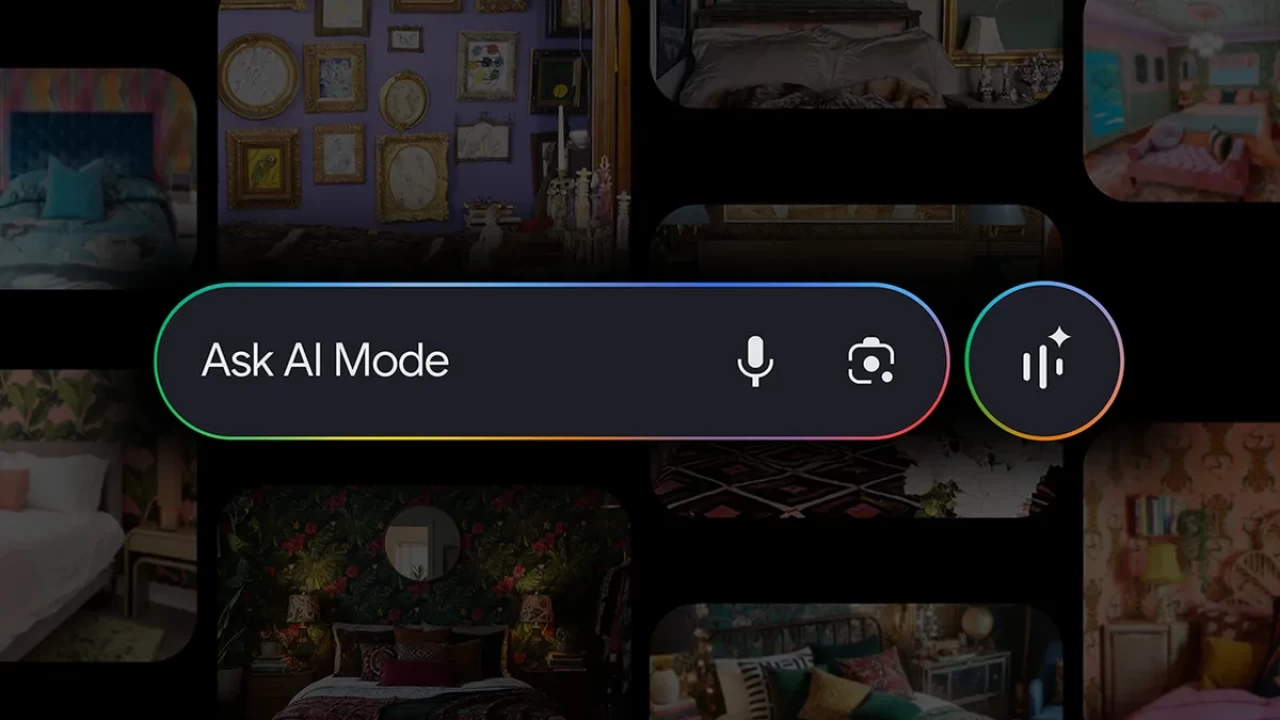

Recientemente, Google ha dado a conocer una serie de mejoras para su modo IA en la búsqueda, una función que debutó a principios de este año. Esta actualización permitirá a los usuarios iniciar búsquedas subiendo o seleccionando imágenes, además de hacer preguntas de seguimiento conversacionales sobre ellas. La nueva tecnología de «búsqueda visual en abanico» permitirá a la IA analizar múltiples elementos dentro de las imágenes, tanto objetos principales como secundarios, y ofrecer resultados visuales altamente relevantes.

Gracias a esta nueva funcionalidad, los jugadores ya no necesitarán usar filtros para refinar sus búsquedas. En lugar de eso, podrán describir visualmente lo que desean, como buscar «inspiración para un dormitorio maximalista» con preferencia por «tonos oscuros». Esta capacidad de búsqueda multimodal, que combina texto e imágenes, está impulsada por los modelos de IA Gemini de Google, los cuales se integran con la infraestructura de búsqueda actual de la compañía para ofrecer respuestas actualizadas y contextuales.

Búsqueda multimodal

La búsqueda multimodal de Google permite a los usuarios incorporar imágenes junto con texto para refinar o mejorar sus consultas. Esta funcionalidad se ve potenciada por la infraestructura de búsqueda actual de Google, que incluye Google Lens y la búsqueda de imágenes, combinada con las capacidades multimodales y de lenguaje avanzadas de Gemini 2.5. Esto no solo mejora la experiencia de búsqueda, sino que también facilita la integración con plataformas de compra basadas en IA.

Google también ha incorporado su tecnología de IA en la Búsqueda, permitiendo a los usuarios describir lo que desean comprar de manera conversacional. Por ejemplo, se puede buscar «vaqueros rectos que no sean demasiado holgados» o «más opciones para la altura del tobillo». Esta funcionalidad se apoya en Shopping Graph, una base de datos en vivo con más de 50 mil millones de listados de productos que se actualizan cada hora, garantizando recomendaciones de productos nuevas, relevantes y personalizadas.

Shopping Graph

El Shopping Graph de Google permite a los usuarios ver productos de tiendas de todo el mundo, desde grandes minoristas hasta tiendas locales, cada una con detalles como reseñas, últimas ofertas, colores y disponibilidad. Esto significa que solo se verán los resultados de compra más recientes, ya que cada hora se actualizan más de 2 mil millones de esas fichas de producto en Google.

La experiencia de búsqueda mejorada del modo IA de Google se lanzará en EE. UU. esta semana. Esta nueva funcionalidad promete revolucionar la manera en que los usuarios interactúan con la búsqueda y la compra en línea, ofreciendo una experiencia más intuitiva y personalizada.

Además de las mejoras en la búsqueda, Google ha anunciado que su tecnología de IA también se integrará con plataformas de compra como Shopify, siguiendo el ejemplo de ChatGPT. Esta integración permitirá a los usuarios realizar compras basadas en IA, describiendo lo que desean comprar de manera conversacional y obteniendo recomendaciones personalizadas y actualizadas.

La combinación de la comprensión visual de primer nivel de Google Search con Lens y la búsqueda de imágenes, junto con las capacidades multimodales y de lenguaje avanzadas de Gemini 2.5, promete una experiencia de búsqueda y compra más fluida y efectiva. Los usuarios podrán describir visualmente lo que desean, desde inspiración para la decoración hasta productos específicos, y obtener resultados altamente relevantes y actualizados.